الذكاء الاصطناعي القابل للتدقيق في مقابل مشكلة الصندوق الأسود للذكاء الاصطناعي

إن المخاوف المحيطة بالذكاء الاصطناعي تستند كلها إلى أحد نوعين من الجهل. النوع الأول ينبع من الخيال وحكايات الخيال العلمي في رؤوس أولئك الذين لا يفهمون ما هو الذكاء الاصطناعي وما ليس كذلك. والنوع الثاني ينبع من الافتقار الحقيقي للمعلومات، وتحديدا عدم قدرة أي شخص ماهر في الذكاء الاصطناعي على رؤية ما تفعله النماذج للوصول إلى قرارات فردية ــ الصندوق الأسود للذكاء الاصطناعي الذي لا يمكن اختراقه. والشركات التي لا تستطيع أن ترى كيف يتخذ الذكاء الاصطناعي كل قرار معرضة للخطر ماليا وسمعة وقانونيا. والواقع أن جو الجهل السائد ــ الذي يتشكل من الخوف غير المنطقي والآخر من الافتقار إلى المعلومات ــ غير مقبول. ولكن يبدو كسر الصندوق الأسود للذكاء الاصطناعي أمرا لا يمكن تحقيقه. ومع ذلك فقد تم إحراز تقدم ملحوظ في جعل الذكاء الاصطناعي قابلا للتدقيق ــ وهي خطوة مهمة في إقناع الذكاء الاصطناعي بالكشف عن أسراره.

يقول الدكتور عدنان مسعود، كبير مهندسي الذكاء الاصطناعي في شركة “إنتل”: “إن مفهوم الذكاء الاصطناعي القابل للتدقيق يتجاوز مبادئ الذكاء الاصطناعي المسؤول، الذي يركز على جعل أنظمة الذكاء الاصطناعي قوية وقابلة للتفسير وأخلاقية وفعالة. وفي حين أن هذه المبادئ ضرورية، فإن الذكاء الاصطناعي القابل للتدقيق يخطو خطوة أبعد من خلال توفير الوثائق والسجلات اللازمة لتسهيل المراجعات التنظيمية وبناء الثقة بين أصحاب المصلحة، بما في ذلك العملاء والشركاء وعامة الناس”. جامعة العلوم والتكنولوجيا، وهي شركة عالمية تقدم الحلول الرقمية والمنصات وهندسة المنتجات وخدمات الابتكار. كما يعمل مسعود باحثًا زائرًا في مختبر الذكاء الاصطناعي بجامعة ستانفورد حيث يعمل بشكل وثيق مع الأوساط الأكاديمية والصناعة.

ولكن كيف يمكن للذكاء الاصطناعي القابل للتدقيق أن يوجد في غياب الذكاء الاصطناعي القابل للتفسير؟ كيف يمكنك تدقيق شيء لا يمكنك تتبعه؟

يقول كريستوف هورومبولي، نائب الرئيس لإدارة مخاطر الذكاء الاصطناعي في شركة “إن الإجابة على هذه الأسئلة تعتمد على ما إذا كنت تتحدث ببساطة عن تدقيق مدخلات ومخرجات الذكاء الاصطناعي، لأن هذا أمر سهل. أم أننا نتحدث عن التدقيق من أجل الشفافية والقدرة على تفسير الذكاء الاصطناعي نفسه، وهو أمر صعب للغاية؟” العقل الصالح، شركة إدارة مخاطر نموذج الذكاء الاصطناعي.

حان الوقت لإلقاء نظرة فاحصة على خيارات التدقيق بالذكاء الاصطناعي والتفكير في FICO كدراسة حالة للنجاح من خلال إنشاء مسارها الفريد في تدقيق الذكاء الاصطناعي لحماية درجات الائتمان للجميع.

خيارات تدقيق الذكاء الاصطناعي

أولاً، ضع في اعتبارك أن أنظمة الذكاء الاصطناعي ليست كلها متساوية، ولا حتى مطوريها أو مستخدميها. وهذا يعني أن أنواع التدقيق والأساليب ومستويات الصعوبة قد تختلف وتختلف بالفعل.

“هناك عدة أنواع مختلفة من عمليات تدقيق الذكاء الاصطناعي. أحد هذه الأنواع هو تدقيق حوكمة المنظمة القياسي إلى حد ما حيث يبحث المدققون عن الالتزام بسياسات الذكاء الاصطناعي الخاصة بالمنظمة،” يوضح أندرو جامينو تشيونج، كبير مسؤولي التكنولوجيا والمؤسس المشارك في Trustible، وهي شركة تقدم برامج حوكمة الذكاء الاصطناعي المسؤولة.

على سبيل المثال، يشير جامينو تشيونج إلى التقرير الذي نُشر مؤخرًا معيار ISO 42001، ويقول إن هذا النوع من التدقيق على مستوى المنظمة “يركز بشكل كبير على هذا النوع من التدقيق”. ويوضح أن هذا النوع من التدقيق على الذكاء الاصطناعي يتكون من إظهار المسارات الورقية للموافقات، والتوثيق الجيد، والدليل على الضوابط المناسبة.

“وفي المقابل، هناك أيضًا تدقيق تقني للغاية على مستوى النموذج. على سبيل المثال، يتطلب قانون نيويورك المحلي رقم 144 المتعلق بتحيز الذكاء الاصطناعي في نظام التوظيف إجراء تدقيق على مستوى النموذج حيث يتعين على المطور إثبات أن نموذجه يجتاز اختبارات إحصائية معينة”، يضيف جامينو تشيونج.

تختلف الأساليب أيضًا، ولكنها تأتي عمومًا من طريقتين رئيسيتين: سجلات الإدخال والإخراج، أو حوكمة بيانات التدريب.

يقول كيفن ماركوس، كبير مسؤولي التكنولوجيا في شركة “إنكوير”: “هناك جانبان للتدقيق: جانب بيانات التدريب، وجانب المخرجات. يتضمن جانب بيانات التدريب مصدر البيانات، وحقوق استخدامها، والنتائج، وما إذا كان من الممكن تتبع النتائج لإظهار المنطق والصحة”. فيرسيوم، مزود أدوات البيانات ومنصة التسويق.

ويضيف ماركوس: “إن جانب الإخراج أكثر تعقيدًا. فبعض الخوارزميات، مثل الشبكات العصبية، لا يمكن تفسيرها، ومن الصعب تحديد سبب إنتاج نتيجة ما. وتتيح خوارزميات أخرى مثل هياكل الشجرة إمكانية تتبع واضحة للغاية لإظهار كيفية إنتاج النتيجة”.

اليوم، تعتمد العديد من الشركات – وخاصة تلك الموجودة في الصناعات الأقل تنظيماً – على سجلات الإدخال/الإخراج كمسار تدقيق لها.

“بالنسبة لي، فإن مسار التدقيق يعني فقط وجود سجل لما حدث ومتى، ولكن [the log] “لن نتطرق إلى ما حدث بين المدخلات والمخرجات”، كما يقول Horompoly من ValidMind.

وبعبارة أخرى، يظل الصندوق الأسود، الذي يحتوي على كل ما حدث بين المدخلات والمخرجات، سليمًا. وفي هذه الطريقة، يتم تدقيق النتائج المتعلقة بالاستعلام، وليس الحسابات التي أدت إلى الإخراج. ويظل تدقيق ما يحدث هناك هو التحدي الأعظم. وهو يشكل تحديًا أكبر في نماذج الذكاء الاصطناعي التوليدي.

يقول ستيفن درو، كبير مسؤولي الذكاء الاصطناعي في شركة “إن نماذج التعلم الآلي التقليدية، مثل الانحدار الخطي وأشجار القرار، أسهل في التدقيق والشرح بسبب شفافيتها. وعلى النقيض من ذلك، فإن نماذج اللغة الكبيرة (LLMs) التي تستخدم الشبكات العصبية أكثر غموضًا، مما يجعل من الصعب تتبع وفهم عمليات صنع القرار الخاصة بها”. RNL، وهي شركة تقدم خدمات وإدارة التسجيل في التعليم العالي، ونجاح الطلاب، ومنتجات وجمع التبرعات.

ويضيف درو: “لهذا السبب، نحاول تجنب تكسير الجوز بالمطارق الثقيلة، وهذا يعني أننا نستخدم نماذج الذكاء الاصطناعي عند الحاجة ولكننا نسعى دائمًا إلى حل المشكلات باستخدام نماذج الذكاء الاصطناعي باستخدام أبسط وأكثر هندسة قابلة للتفسير للمهمة”.

FICO يحقق فوزًا

ورغم التحديات، فقد أحرزت بعض الشركات تقدماً ملموساً في عدد من الأساليب الجديدة.

خذ هذا المثال، فيكو، الشركة التي يعتمد عليها العالم في خدمات تقييم مخاطر الائتمان. بدأت الشركة العمل بالتحليلات وكميات هائلة من البيانات منذ الخمسينيات. ظهرت درجات FICO الشهيرة الآن في حوالي عام 1989، بعد حوالي سبع سنوات من بدء الشركة في إصدار تقنيات الشبكة العصبية للكشف عن الاحتيال المالي. إن القول بأن FICO لديها تاريخ طويل في تشغيل الذكاء الاصطناعي والتعلم الآلي والتحليلات هو أقل من الحقيقة.

اليوم، يشغل سكوت زولدي منصب كبير مسؤولي التحليلات في شركة FICO بعد أن ارتقى في المناصب على مدار السنوات الخمس والعشرين الماضية وما زال مستمراً. وبكل المقاييس، فهو باحث نشط للغاية في مجال الذكاء الاصطناعي. وخلال ربع قرن من الخدمة في شركة FICO، ركز على تطوير خوارزميات فريدة لتلبية متطلبات الذكاء الاصطناعي والتعلم الآلي المحددة لعملائها، وهم في الغالب مؤسسات مالية. كما ألف حوالي 138 براءة اختراع لشركة FICO في نفس الفترة الزمنية.

“عندما كنت طالبًا، كان الأمر كله يدور حول محاولة إيجاد النظام وسط الفوضى. وهذا يصف حياتي اليومية هنا في FICO في بعض الأحيان مع البيانات. لدي اعتقاد أساسي بأن وراء كل البيانات هيكل. والأمر متروك لنا لإيجاد الهيكل الذي يفسر السلوك. وإذا تمكنا من القيام بذلك، فستكون لديك نماذج تنبؤية، ويمكنك استخدام هذه الأدوات لاتخاذ القرارات”، كما يقول زولدي.

ولكن من السهل بالطبع قول ذلك أكثر من فعله. فبعد سنوات من العمل مع أنواع مختلفة من الذكاء الاصطناعي، صقلت شركة FICO طريقة فريدة لتطوير نماذج الذكاء الاصطناعي التي تلبي معايير صارمة في المساءلة والإنصاف. قبل لقد تم نشرهم.

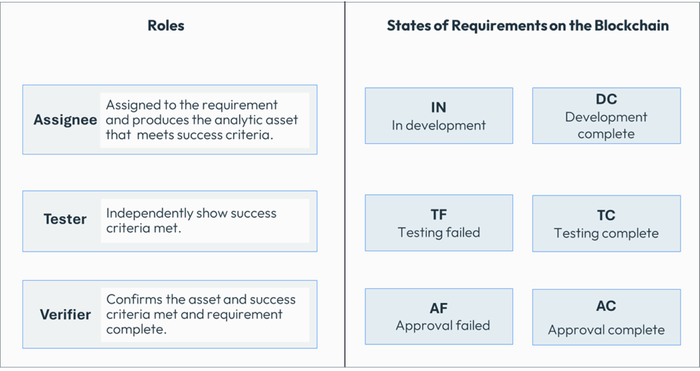

“لدينا مسار ضيق للغاية لكيفية تطوير النماذج، لأنني لا أستطيع أن أجعل 400 عالم بيانات يبنيون النماذج بـ 400 طريقة مختلفة، أليس كذلك؟ يجب بناؤها وفقًا لمعيار. ويتم بعد ذلك تدوين هذا المعيار على blockchain،” كما أوضح.

تتم عملية استخدام FICO على النحو التالي:

-

لقد بدأ مشروع يتطلب بناء نموذج الذكاء الاصطناعي.

-

هناك مجموعة من 28 متطلبًا مختلفًا يجب أن يستوفيها كل نموذج جديد ليكون متوافقًا مع معيار تطوير النموذج الخاص بشركة FICO وقبل إصدار النموذج الجديد.

-

يتم إدخال المتطلبات والتحققات اللاحقة للامتثال على blockchain.

-

بمجرد استيفاء جميع المتطلبات واختبارها والتحقق من صحتها، يتم بعد ذلك نشر نموذج الذكاء الاصطناعي.

“أقوم بتعيين من سيقوم بالعمل، ومن سيختبر أداء كل مهمة بشكل صحيح، ومن سيتحقق من أن كل من عالم الذكاء الاصطناعي والمختبر قاما بعملهما بشكل صحيح؟ كل هذه المعلومات موجودة على blockchain،” كما يقول زولدي.

“الآن، إذا تم ذلك بشكل غير صحيح، فإنه موجود على blockchain. إذا تم ذلك بشكل صحيح، فإنه موجود على blockchain. لكنه سجل غير قابل للتغيير لكيفية اتباع معيار تطوير النموذج بالضبط وأين تم استيفاء معايير النجاح أم لا. ويمكننا تسليم ذلك إلى فريق حوكمة أو جهة تنظيمية أو فريق قانوني للتفتيش حتى لا يكون هناك نقاش حول ما هو موجود في النموذج،” يضيف زولدي.

إذا فشل نموذج ما في أي خطوة، فسيتم إعادته لمزيد من التقييم أو المراجعة، أو سيتم التخلص منه. لا يتم نشر نموذج الذكاء الاصطناعي إلا إذا نجح في كل خطوة.

مع تقدم مشروع النمذجة، يمر المتطلب بمراحل مختلفة تنتهي بنموذج معتمد أو نموذج مرفوض. الرسم البياني مقدم من FICO.

أين تقف الذكاء الاصطناعي القابل للتدقيق الآن؟

يقول فال هيرارد، الرئيس التنفيذي لشركة “إن فوائد الذكاء الاصطناعي القابل للتدقيق كبيرة. نحن نتطلع إلى زيادة الشفافية والثقة، وإدارة أفضل للمخاطر، وتحسين الامتثال التنظيمي، وتعزيز القدرة على تحديد التحيزات وتصحيحها، وزيادة المساءلة في اتخاذ القرارات المتعلقة بالذكاء الاصطناعي”. سيفر، وهي شركة تكنولوجيا مالية للذكاء الاصطناعي.

“ومع ذلك، يتعين علينا أيضًا أن ندرك التحديات. فتعقيد أنظمة الذكاء الاصطناعي، وخاصة برامج الماجستير في القانون، والطبيعة كثيفة الموارد لأدوات التدقيق، والمجال سريع التطور الذي يتطلب تحديثات مستمرة، والافتقار إلى الإجراءات الموحدة والحاجة إلى الخبرة المتخصصة، كلها عقبات نواجهها”، يضيف هيرارد.

يظل تطوير الذكاء الاصطناعي القابل للتفسير هو الهدف الأسمى، والعديد من فرق الذكاء الاصطناعي تسعى جاهدة للعثور عليه. وحتى ذلك الحين، هناك العديد من الجهود الجارية لتطوير طرق مختلفة لمراجعة الذكاء الاصطناعي من أجل الحصول على قبضة أقوى على سلوكه وأدائه. ومن المؤسف أنه لا يوجد عدد كاف من الأشخاص الذين يعملون على هذه القضية.

يقول كجيل كارلسون، رئيس استراتيجية الذكاء الاصطناعي في Domino Data Lab: “إن الذكاء الاصطناعي القابل للتدقيق هو نقطة البداية لجميع أشكال تنظيم الذكاء الاصطناعي الحالية والمستقبلية. ومن المؤسف أن وجوده نادر للغاية أيضًا خارج فرق علوم البيانات المتقدمة في الصناعات الخاضعة للتنظيم الشديد مثل الخدمات المالية والتأمين والأدوية الحيوية”.

لقد كان هناك الكثير من الكلام عن الذكاء الاصطناعي المسؤول، والذي غالبًا ما يتبين أنه ليس أكثر من مجرد كلام فارغ في التسويق. ترقب الدليل على أن الذكاء الاصطناعي المستخدم يعمل كما هو مذكور.