تعلن Nvidia عن شريحة GB200 Blackwell AI، والتي سيتم إطلاقها في وقت لاحق من هذا العام

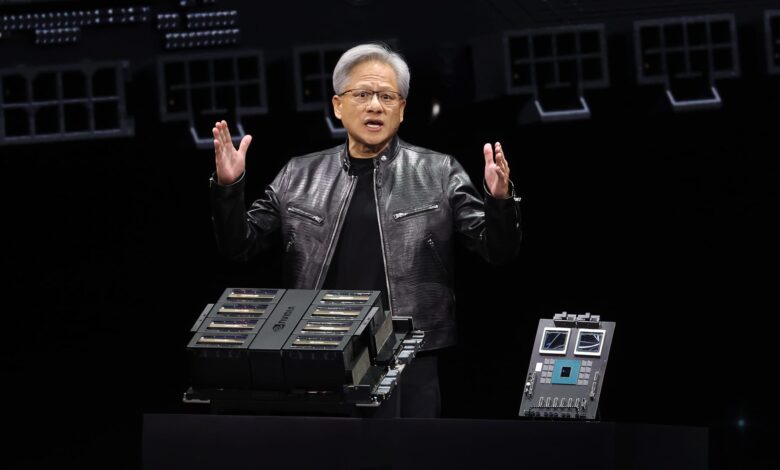

يلقي الرئيس التنفيذي لشركة Nvidia Jensen Huang خطابًا رئيسيًا خلال مؤتمر Nvidia GTC للذكاء الاصطناعي في مركز SAP في 18 مارس 2024 في سان خوسيه، كاليفورنيا.

جاستن سوليفان | صور جيتي

نفيديا أعلنت يوم الاثنين عن جيل جديد من رقائق وبرامج الذكاء الاصطناعي لتشغيل نماذج الذكاء الاصطناعي. ويأتي هذا الإعلان، الذي تم الإعلان عنه خلال مؤتمر مطوري Nvidia في سان خوسيه، في الوقت الذي تسعى فيه شركة تصنيع الرقائق إلى تعزيز مكانتها كمورد رئيسي لشركات الذكاء الاصطناعي.

ارتفع سعر سهم Nvidia بمقدار خمسة أضعاف وتضاعف إجمالي المبيعات بأكثر من ثلاثة أضعاف منذ أن أطلق ChatGPT من OpenAI طفرة الذكاء الاصطناعي في أواخر عام 2022. تعد وحدات معالجة الرسومات للخادم المتطورة من Nvidia ضرورية لتدريب ونشر نماذج الذكاء الاصطناعي الكبيرة. الشركات مثل مايكروسوفت و ميتا أنفقت مليارات الدولارات لشراء الرقائق.

يُطلق على الجيل الجديد من معالجات الرسوميات التي تعمل بتقنية الذكاء الاصطناعي اسم Blackwell. تسمى شريحة Blackwell الأولى GB200 وسيتم شحنها في وقت لاحق من هذا العام. تعمل شركة Nvidia على إغراء عملائها بشرائح أكثر قوة لتحفيز الطلبات الجديدة. على سبيل المثال، لا تزال الشركات وصانعو البرمجيات يسعون جاهدين للحصول على الجيل الحالي من رقائق “Hopper” H100 والرقائق المماثلة.

وقال جنسن هوانغ، الرئيس التنفيذي لشركة Nvidia، يوم الاثنين في مؤتمر مطوري الشركة في كاليفورنيا: “إن Hopper رائع، لكننا بحاجة إلى وحدات معالجة رسوميات أكبر”.

انخفضت أسهم Nvidia بأكثر من 1٪ في تعاملات ممتدة يوم الاثنين.

قدمت الشركة أيضًا برنامجًا مدرًا للدخل يسمى NIM والذي سيسهل نشر الذكاء الاصطناعي، مما يمنح العملاء سببًا آخر للاستمرار في استخدام شرائح Nvidia. مجال متزايد من المنافسين.

يقول المسؤولون التنفيذيون في شركة Nvidia إن الشركة أصبحت أقل من مجرد مزود شرائح مرتزقة، وأكثر من مجرد مزود منصات، مثل Microsoft أو Apple، حيث يمكن لشركات أخرى بناء البرامج عليها.

وقال هوانغ: “إن بلاكويل ليست شريحة، بل هي اسم منصة”.

قال نائب رئيس مؤسسة Nvidia Manuvir Das في مقابلة: “كان المنتج التجاري القابل للبيع هو وحدة معالجة الرسومات وكان البرنامج يهدف إلى مساعدة الأشخاص على استخدام وحدة معالجة الرسومات بطرق مختلفة”. “بالطبع، ما زلنا نفعل ذلك. ولكن ما تغير حقًا هو أن لدينا الآن شركة برمجيات تجارية.”

وقال داس إن برنامج Nvidia الجديد سيسهل تشغيل البرامج على أي من وحدات معالجة الرسومات الخاصة بـ Nvidia، حتى تلك القديمة التي قد تكون أكثر ملاءمة للنشر ولكن ليس لبناء الذكاء الاصطناعي.

“إذا كنت مطورًا، فلديك نموذج مثير للاهتمام تريد أن يتبناه الأشخاص، وإذا قمت بوضعه في NIM، فسوف نتأكد من أنه قابل للتشغيل على جميع وحدات معالجة الرسومات لدينا، حتى تتمكن من الوصول إلى الكثير من الأشخاص، ” قال داس.

تعرف على بلاكويل، خليفة هوبر

Nvidia’s GB200 Grace Blackwell Superchip، مع معالجين رسوميات B200 ومعالج مركزي واحد قائم على Arm.

تقوم Nvidia كل عامين بتحديث بنية وحدة معالجة الرسومات الخاصة بها، مما يفتح قفزة كبيرة في الأداء. تم تدريب العديد من نماذج الذكاء الاصطناعي التي تم إصدارها خلال العام الماضي على بنية Hopper الخاصة بالشركة – والتي تستخدمها شرائح مثل H100 – والتي تم الإعلان عنها في عام 2022.

تقول Nvidia إن المعالجات المستندة إلى Blackwell، مثل GB200، تقدم ترقية هائلة للأداء لشركات الذكاء الاصطناعي، مع 20 بيتافلوب في أداء الذكاء الاصطناعي مقابل 4 بيتافلوب لـ H100. وقالت نفيديا إن قوة المعالجة الإضافية ستمكن شركات الذكاء الاصطناعي من تدريب نماذج أكبر وأكثر تعقيدًا.

تتضمن الشريحة ما تسميه Nvidia “محرك المحولات المصمم خصيصًا لتشغيل الذكاء الاصطناعي القائم على المحولات، وهي إحدى التقنيات الأساسية التي يقوم عليها ChatGPT.

وحدة معالجة الرسومات Blackwell كبيرة الحجم وتجمع بين قالبين تم تصنيعهما بشكل منفصل في شريحة واحدة تم تصنيعها بواسطة TSMC. سيكون متاحًا أيضًا كخادم كامل يسمى GB200 NVLink 2، يجمع بين 72 وحدة معالجة رسوميات Blackwell وأجزاء Nvidia الأخرى المصممة لتدريب نماذج الذكاء الاصطناعي.

الرئيس التنفيذي لشركة Nvidia Jensen Huang يقارن حجم شريحة “Blackwell” الجديدة مع شريحة “Hopper” H100 الحالية في مؤتمر مطوري الشركة، في سان خوسيه، كاليفورنيا.

نفيديا

أمازون, جوجل, مايكروسوفت، و وحي سوف تبيع الوصول إلى GB200 من خلال الخدمات السحابية. يجمع GB200 بين وحدتي معالجة رسوميات B200 Blackwell مع وحدة معالجة مركزية Grace واحدة قائمة على Arm. وقالت Nvidia إن Amazon Web Services ستقوم ببناء مجموعة خوادم تحتوي على 20000 شريحة GB200.

وقالت نفيديا إن النظام يمكنه نشر نموذج يحتوي على 27 تريليون معلمة. وهذا أكبر بكثير حتى من أكبر النماذج، مثل GPT-4، الذي يقال إنه يحتوي على 1.7 تريليون معلمة. يعتقد العديد من الباحثين في مجال الذكاء الاصطناعي أن النماذج الأكبر تحتوي على المزيد من المعلمات والبيانات يمكن أن يفتح قدرات جديدة.

لم تقدم Nvidia تكلفة لـ GB200 الجديد أو الأنظمة المستخدمة فيها. وتتراوح تكلفة H100 المستندة إلى Hopper من Nvidia بين 25000 دولار و40000 دولار لكل شريحة، مع أنظمة كاملة تكلف ما يصل إلى 200000 دولار، وفقًا لتقديرات المحللين.

ستقوم Nvidia أيضًا ببيع معالجات الرسوميات B200 كجزء من نظام كامل يشغل رف الخادم بالكامل.

نفيديا الاستدلال الخدمات الصغيرة

أعلنت Nvidia أيضًا أنها تضيف منتجًا جديدًا يسمى NIM، والذي يرمز إلى Nvidia Inference Microservice، إلى اشتراكها في برنامج Nvidia Enterprise.

تعمل NIM على تسهيل استخدام وحدات معالجة الرسوميات القديمة من Nvidia للاستدلال، أو عملية تشغيل برامج الذكاء الاصطناعي، وستسمح للشركات بمواصلة استخدام مئات الملايين من وحدات معالجة الرسومات Nvidia التي تمتلكها بالفعل. يتطلب الاستدلال قوة حسابية أقل من التدريب الأولي لنموذج الذكاء الاصطناعي الجديد. تتيح NIM للشركات التي ترغب في تشغيل نماذج الذكاء الاصطناعي الخاصة بها، بدلاً من شراء الوصول إلى نتائج الذكاء الاصطناعي كخدمة من شركات مثل OpenAI.

تتمثل الإستراتيجية في حث العملاء الذين يشترون خوادم تعتمد على Nvidia على الاشتراك في Nvidia Enterprise، والذي يكلف 4500 دولارًا لكل وحدة معالجة رسومات سنويًا للحصول على ترخيص.

ستعمل Nvidia مع شركات الذكاء الاصطناعي مثل Microsoft أو Hugging Face لضمان ضبط نماذج الذكاء الاصطناعي الخاصة بها لتعمل على جميع شرائح Nvidia المتوافقة. بعد ذلك، باستخدام NIM، يمكن للمطورين تشغيل النموذج بكفاءة على خوادمهم الخاصة أو خوادم Nvidia المستندة إلى السحابة دون عملية تكوين طويلة.

قال داس: “في الكود الخاص بي، حيث كنت أتصل بـ OpenAI، سأستبدل سطرًا واحدًا من الكود لتوجيهه إلى NIM الذي حصلت عليه من Nvidia بدلاً من ذلك”.

وتقول Nvidia إن البرنامج سيساعد أيضًا الذكاء الاصطناعي على العمل على أجهزة الكمبيوتر المحمولة المجهزة بوحدة معالجة الرسومات، بدلاً من الخوادم الموجودة في السحابة.