يحذر كبار العلماء من خارج السيطرة من الذكاء الاصطناعي

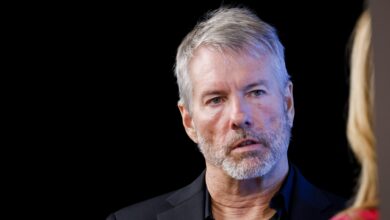

يناقش Yoshua Bengio (L) و Max Tegmark (R) تطوير الذكاء العام الاصطناعي خلال تسجيل بودكاست مباشر لـ CNBC’s “Beyond the Valley” في دافوس ، سويسرا في يناير 2025.

CNBC

وقال اثنان من علماء الذكاء الاصطناعى في العالم لـ CNBC إن الذكاء العام المصطنعة المصنوع من “الوكلاء” قد يكون خطيرًا لأن منشئيها قد يفقدون السيطرة على النظام.

في أحدث حلقة من CNBC’s “وراء الوادي” تم إصدار بودكاست يوم الثلاثاء ، ماكس تيجارك ، أستاذ في معهد ماساتشوستس للتكنولوجيا ورئيس معهد مستقبل الحياة ، ويوشوا بينجيو ، الذي أطلق عليه اسم “العرابين من الذكاء الاصطناعى” وأستاذ في جامعة مونتريال مخاوفهم بشأن الذكاء العام الاصطناعي ، أو AGI. يشير المصطلح على نطاق واسع إلى أنظمة الذكاء الاصطناعى الأكثر ذكاءً من البشر.

تنبع مخاوفهم من أكبر الشركات في العالم التي تتحدث الآن عن “وكلاء الذكاء الاصطناعي” أو “Aulectic AI” – التي تدعي الشركات التي ستسمح لـ AI chatbots بالتصرف مثل المساعدين أو الوكلاء والمساعدة في العمل والحياة اليومية. تختلف تقديرات الصناعة إلى متى سيأتي AGI إلى حيز الوجود.

مع هذا المفهوم ، يأتي فكرة أن أنظمة الذكاء الاصطناعى يمكن أن يكون لها “وكالة” وأفكار خاصة بها ، وفقًا لبنجيو.

“لقد استلهم الباحثون في الذكاء الاصطناعى الذكاء البشري لبناء ذكاء الآلة ، وفي البشر ، هناك مزيج من القدرة على فهم العالم مثل الذكاء الخالص والسلوك الواعي ، وهذا يعني … لاستخدام معرفتك لتحقيق الأهداف ، “قال بنغو لـ CNBC” وراء الوادي “.

“في الوقت الحالي ، هذه هي الطريقة التي نبني بها AGI: نحن نحاول جعلهم وكلاء يفهمون الكثير عن العالم ، ومن ثم يمكن أن يتصرفوا وفقًا لذلك. لكن هذا في الواقع اقتراح خطير للغاية.”

وأضاف بنجو أن متابعة هذا النهج سيكون مثل “إنشاء نوع جديد أو كيان ذكي جديد على هذا الكوكب” و “عدم معرفة ما إذا كانوا سيتصرفون بطرق تتفق مع احتياجاتنا”.

“بدلاً من ذلك ، يمكننا أن نفكر ، ما هي السيناريوهات التي تسير فيها الأمور بشكل سيء وتعتمد جميعها على الوكالة؟ وبعبارة أخرى ، فذلك لأن الذكاء الاصطناعى له أهدافه الخاصة التي يمكن أن نكون في مشكلة”.

وقال بنغو إن فكرة الحفاظ على الذات يمكن أن تبدأ أيضًا ، حيث أن الذكاء الاصطناعى يصبح أكثر ذكاءً.

“هل نريد أن نكون في منافسة مع كيانات أكثر ذكاءً منا؟ إنها ليست مقامرة مطمئنة للغاية ، أليس كذلك؟ لذلك علينا أن نفهم كيف يمكن أن يظهر الحفاظ على الذات كهدف في الذكاء الاصطناعي.”

أدوات AI المفتاح

بالنسبة إلى TEGMARK الخاص بـ MIT ، يكمن المفتاح في ما يسمى “Tool AI”-الأنظمة التي يتم إنشاؤها لغرض محدد محدد ، ولكن لا يجب أن تكون وكلاء.

قال Tegmark إن أداة AI يمكن أن تكون نظامًا يخبرك بكيفية علاج السرطان ، أو شيء يمتلك “بعض الوكالة” مثل سيارة ذاتية القيادة “حيث يمكنك إثبات أو الحصول على ضمانات عالية وموثوقة حقًا أنك ما زلت ستكون قادرة على السيطرة عليه “.

وقال تيجارك: “أعتقد ، في ملاحظة متفائلة هنا ، يمكن أن نحصل على كل ما نحفزه تقريبًا مع الذكاء الاصطناعي … إذا أصرنا ببساطة على وجود بعض معايير السلامة الأساسية قبل أن يتمكن الناس من بيع أنظمة الذكاء الاصطناعى القوية”.

“عليهم أن يثبتوا أنه يمكننا إبقائهم تحت السيطرة. ثم تقوم الصناعة بالابتكار بسرعة لمعرفة كيفية القيام بذلك بشكل أفضل.”

دعا معهد مستقبل الحياة في Tegmark في عام 2023 إلى توقف عن تطوير أنظمة الذكاء الاصطناعى التي يمكن أن تتنافس مع الذكاء على مستوى الإنسان. على الرغم من أن ذلك لم يحدث ، قال Tegmark إن الناس يتحدثون عن هذا الموضوع ، والآن حان الوقت لاتخاذ إجراء لمعرفة كيفية وضع الدرابزين في مكانها للسيطرة على AGI.

وقال تيجارك لـ CNBC’s “Beyond the Valley”: “حتى الآن على الأقل الكثير من الناس يتحدثون عن الحديث. علينا أن نرى ما إذا كان بإمكاننا حملهم على المشي”.

“من الواضح أنه من الجنون بالنسبة لنا أن يبني البشر شيئًا أكثر ذكاءً منا قبل أن نكتشف كيفية التحكم فيه.”

هناك العديد من المشاهدات حول موعد وصول AGI ، مدفوعًا جزئيًا بتعريفات مختلفة.

قال الرئيس التنفيذي لشركة Openai Sam Altman إن شركته تعرف كيفية بناء AGI وقالت إنها ستصل في وقت أقرب مما يعتقد الناس ، على الرغم من أنه قلل من تأثير التكنولوجيا.

“أظن أننا سنضرب Agi في وقت أقرب من أن معظم الناس في العالم يفكرون وسيكون الأمر أقل أهمية” ، Altman قال في ديسمبر.